作者:原创

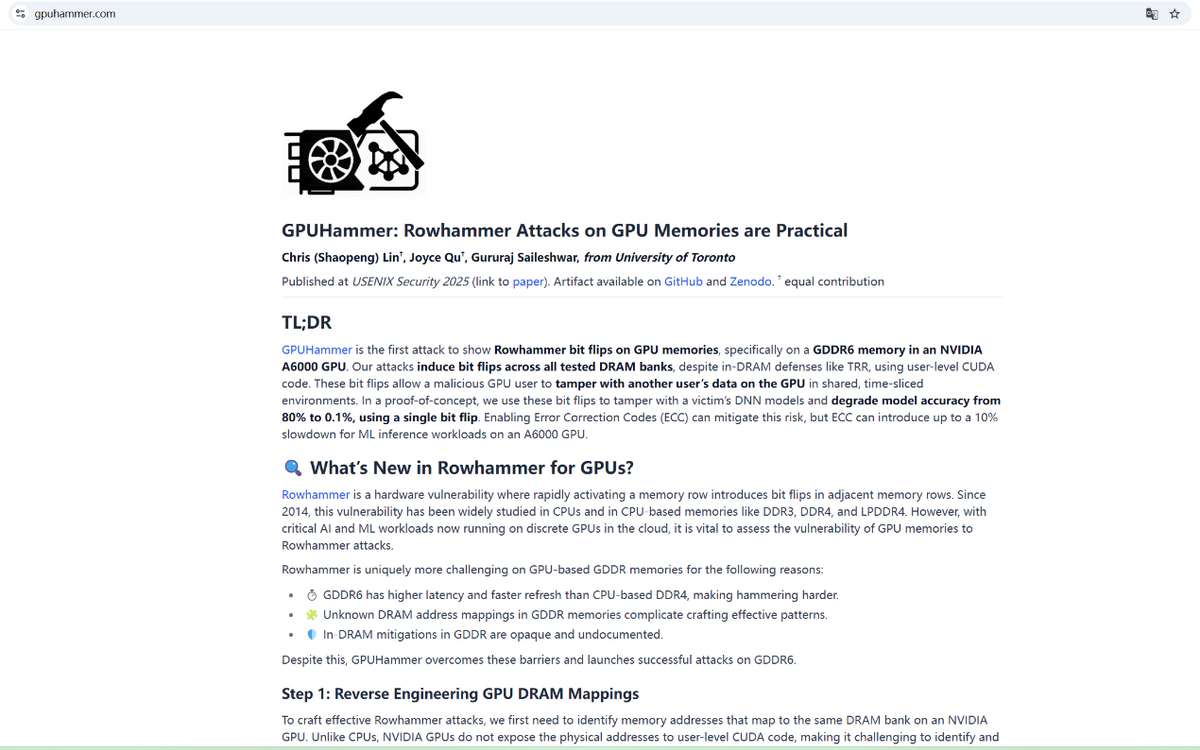

多伦多大学的研究人员展示了RowHammer攻击如何轻易地通过诱导GPU存储体中的比特位翻转,降低GPU上AI模型的准确率。RowHammer漏洞允许攻击者破坏存储单元内的数据,研究人员证明该漏洞同样可影响GPU显存。

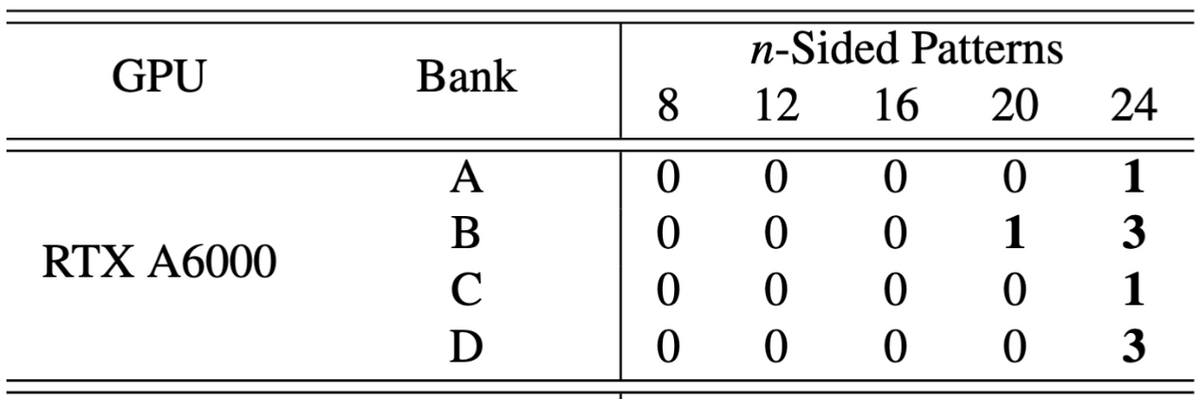

通过在显存(本实验中为NVIDIA RTX A6000的GDDR6)的被测DRAM存储体中诱导比特位翻转,研究人员显著降低了AI模型在GPU上的性能。即使存在诸如DRAM目标刷新率(TRR)这类硬件级防护措施,只需翻转FP16值中的单个比特位,主要ImageNet模型的DNN预测准确率便从80%骤降至仅0.1%。

此前,Rowhammer主要影响DDR4系统内存,但GPUHammer首次证明GDDR6显存 同样易受攻击,而GDDR6正是当前许多英伟达显卡(尤其是用于AI和工作站负载的型号)所采用的显存类型。研究人员指出,即使存在一些防护机制,他们仍然能在多个内存库中引发多比特翻转,甚至完全破坏一个已训练好的AI模型,使其彻底失效。

更令人担忧的是,这种攻击不需要访问你的数据,攻击者只需在云环境或服务器中与你共享同一块GPU,就可能对你的任务进行任意干扰。

该攻击已在RTX A6000上测试成功,但风险波及Ampere、Ada、Hopper和Turing架构的多款GPU,尤其是用于工作站和服务器的型号。NVIDIA已公布受影响型号列表,并建议启用ECC(错误校正码)。不过,像RTX 5090和H100这类新一代GPU已内置芯片级ECC,可自动防护,无需用户干预。

ECC是一种内存冗余机制,可检测并修复此类比特翻转错误。不过,启用ECC会带来轻微的性能损失:机器学习任务约下降10%,可用显存减少约6–6.5%。

如果你只是在家玩游戏或使用个人PC,目前无需过度担心。GPUHammer主要威胁的是共享GPU环境,例如云游戏服务器、AI训练集群或虚拟桌面基础设施(VDI),即多个用户在同一硬件上运行任务的场景。然而,GPU内存可被静默篡改这一事实,对整个行业都是一记警钟,尤其是在AI应用日益普及的今天。

GPUHammer这类攻击不会导致系统崩溃或明显故障,而是直接破坏AI模型的完整性,影响其行为和决策。由于这一切发生在硬件层面,几乎无法察觉,除非你知道该查哪里。在医疗、金融、自动驾驶等受监管行业,这种攻击可能引发严重后果:错误决策、安全漏洞,甚至法律风险。

虽然普通用户暂时不会成为目标,但GPUHammer提醒我们:随着GPU从游戏扩展到 AI、创意和生产领域,内存安全问题已不再可选。

奇谱科技

奇谱科技