作者:原创

摩根士丹利研究公司最新发布的报告中,对比了不同AI解决方案在推理工作负载中的运营成本和利润率。结果显示,大多数运行多芯片进行AI推理的“工厂”或公司,其利润率超过50%,而英伟达在其中处于领先地位。

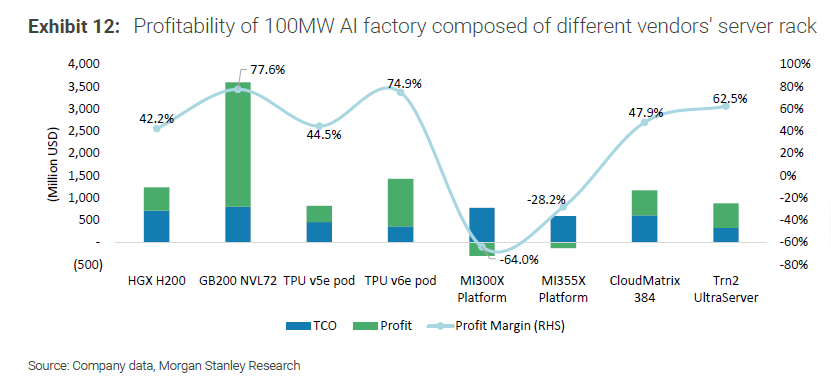

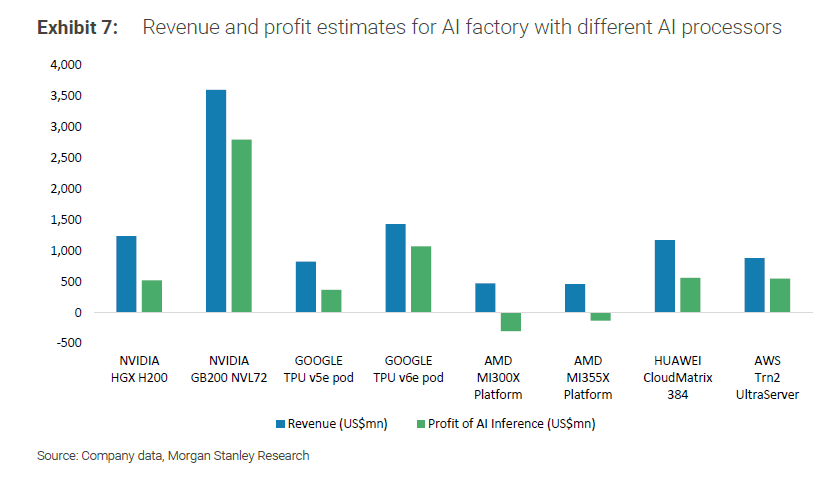

为了进行评估,摩根士丹利选取了一系列功率为100兆瓦的AI“工厂”,这些工厂由不同供应商的服务器机架组成,包括英伟达、谷歌、AMD、AWS和华为的平台。其中,英伟达的GB200 NVL72“Blackwell”GPU平台实现了最高的利润率,达到77.6%,预计利润约为35亿美元。

谷歌凭借TPU v6e pod位居第二,利润率为74.9%,第三名是AWS的Trn2 Ultra服务器,利润率为62.5%,其他解决方案的利润率大多在40%-50%之间。但最值得关注的是AMD的数据,这表明AMD还有大量的工作要做。AMD最新的MI355X平台在AI推理中产生了-28.2%的利润率,而较老的MI300X平台则产生了-64.0%的利润率。

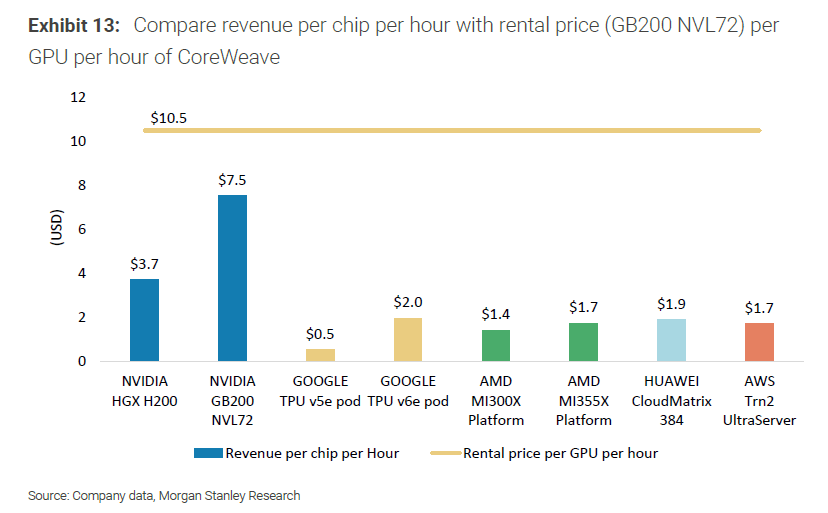

摩根士丹利还根据平均每小时10.5美元的租赁价格,分解了每颗芯片每小时的收入。英伟达的GB200 NVL72芯片每小时可产生7.5美元的收入,排名第二的是英伟达的HGX H200,每小时可产生3.7美元的收入,而AMD的MI355X平台每小时只能产生1.7美元的收入。其他芯片大多每小时只能产生0.5到2.0美元的收入,因此英伟达处于一个完全不同的水平。

英伟达在AI推理方面的巨大领先归功于其对FP4的支持以及对CUDA AI堆栈的持续优化。该公司对其一些较旧的GPU(例如Hopper,甚至是Blackwell)进行了“陈年佳酿”式的优化,这些GPU每个季度都在逐步提升性能。

AMD的MI300和MI350平台在硬件方面也很出色,也一直在进行软件优化,但似乎在AI推理方面仍有需要改进的地方。

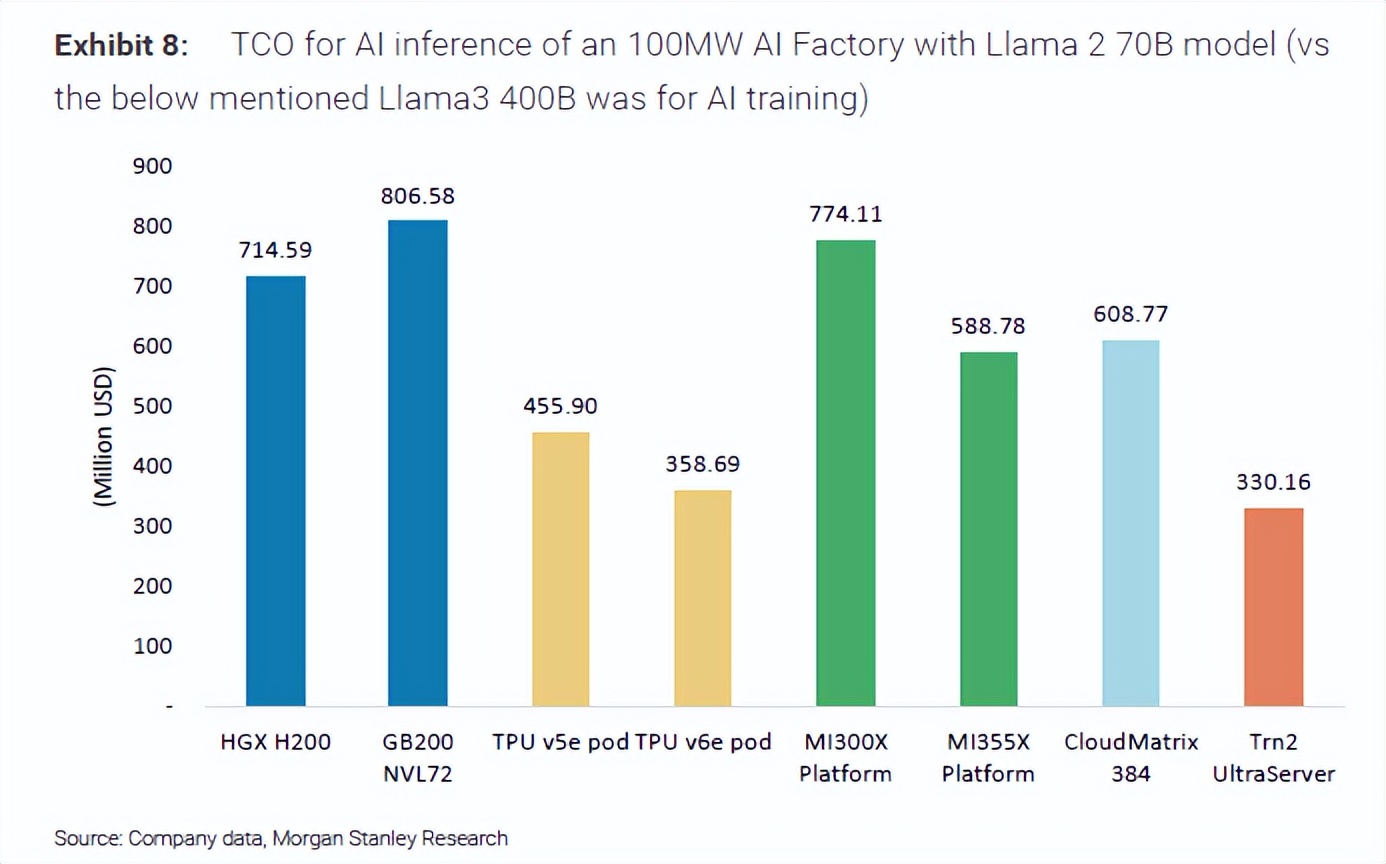

摩根士丹利还强调了另一个问题,即MI300X平台的总拥有成本(TCO)高达7.44亿美元,与英伟达的GB200平台相当,后者的总拥有成本约为8亿美元。因此,成本因素似乎并不利于AMD。

较新的MI355X服务器的预估总拥有成本为5.88亿美元,与华为的CloudMatrix 384相当。较高的初始成本可能是英伟达如此受欢迎的原因之一,因为它们在投资成本上可以与AMD相当,但提供更高的AI推理性能,预计在未来几年中,AI推理将占据AI市场的85%。

奇谱科技

奇谱科技